Medische aansprakelijkheid en artificiële intelligentie

Het gebruik van artificiële intelligentie (AI) in de zorg is de afgelopen jaren sterk toegenomen, dit is vooral terug te zien in de ouderenzorg, diagnostiek en chirurgie. AI wordt al in 63 procent van de ziekenhuizen ingezet en ontwikkelt zich snel. Terwijl de technologie veelbelovende voordelen biedt, roept zij ook zorgen op over veiligheid en aansprakelijkheid. Dit creëert een dilemma tussen het omarmen van technologische vooruitgang en het beschermen van de patiënt. Wat betekent deze ontwikkeling voor het medische aansprakelijkheidsrecht? Wie is verantwoordelijk bij fouten veroorzaakt door AI, zoals verkeerde diagnoses of chirurgische complicaties? Deze vraagstukken vereisen zorgvuldige juridische overwegingen.

1. Inleidend

Afgelopen jaren is het gebruik en de ontwikkeling van artificiële intelligentie (hierna: ‘AI’) in een stroomversnelling beland. Zo wordt AI momenteel in 63 procent van de ziekenhuizen ingezet ter ondersteuning van diagnostiek, maar ook bij de afdelingen prognose (23 procent), radiologie (74 procent) en radiotherapie (13 procent) zijn AI-toepassingen geïmplementeerd. Zelfs generatieve AI wordt in 57 procent van de ziekenhuizen ingezet, denk hierbij aan automatische transcripties en het samenvatten van documenten. Momenteel is er geen enkele technologie in opkomst die zoveel invloed zal hebben op onze maatschappij als AI.1

Deze opkomst gaat gepaard met ambitieuze beloften over de economische en maatschappelijke potentie van AI, maar brengt tegelijkertijd ook zorgen met zich mee. De combinatie van angst en hoge (positieve) verwachtingen zorgt voor een dilemma waarin de overheid moet kiezen tussen het enerzijds investeren in technologie en anderzijds het (tijdig) op de rem trappen. Het handhaven en controleren van dit dilemma vereist actie van de wetgever en toezichthouders, die verantwoordelijk zijn voor het opstellen en implementeren van passende regelgeving.

Het gebruik van AI binnen de medische wereld roept complexe juridische vragen op. Wie is aansprakelijk voor verkeerde diagnoses, chirurgische fouten of onjuiste medicijnverstrekking wanneer AI een ondersteunende rol speelt? Ondanks dat het gebrek aan (Europese) regelgeving en jurisprudentie een eenduidig antwoord op deze vraag blokkeert, zijn er wel aanknopingspunten te vinden in verscheidene rechtsbronnen.

Deze bijdrage onderzoekt in vogelvlucht de wijze waarop een medisch hulpverlener of een producent (contractueel) aansprakelijk kan worden gesteld voor fouten die voortkomen uit beslissingen of handelingen die door AI als (medische) hulpzaak worden genomen binnen de domeinen van diagnostiek, ouderenzorg of chirurgische procedures. Voor de vereiste toerekenbaarheid bij contractuele aansprakelijkheid zal artikel 6:77 BW worden betrokken.

2. Contractuele aansprakelijkheid

Om medische aansprakelijkheid bij het gebruik van AI juridisch in te kaderen lijken twee juridische regimes passende handvatten te geven: contractuele aansprakelijkheid en productaansprakelijkheid. De contractuele aansprakelijkheid is gebaseerd op de behandelingsovereenkomst, zoals vastgelegd in artikel 7:446 BW. Contractuele aansprakelijkheid kan worden gevestigd wanneer de hulpverlener tekortschiet in de nakoming van de behandelingsovereenkomst en deze tekortkoming aan de hulpverlener kan worden toegerekend. De tekortkoming kan – op grond van artikel 6:77 BW – aan de hulpverlener worden toegerekend, indien hij bij de uitvoering van de medische behandelingsovereenkomst gebruikmaakt van een ongeschikte hulpzaak. In de jurisprudentie over hulpzaken, waaronder HR Miragelplombe en PIP-implantaten, benadrukt de Hoge Raad dat een hulpverlener niet verantwoordelijk is voor schade indien een hulpzaak, gemeten naar de stand van de techniek ten tijde van het gebruik, als geschikt werd beschouwd.

Dit lijkt te betekenen dat de ‘state of the art’ van AI de contractuele aansprakelijkheid van de hulpverlener wegens wanprestatie kan begrenzen. Hoewel een nadere omschrijving van het begrip ‘state of the art’ ontbreekt en de toepassing van dit leerstuk op AI nog onbekend is, zal in deze bijdrage ‘state of the art’ worden beschouwd als een verweer tegen wanprestatie.

2.1 Ongeschikte hulpzaak

De kwalificatie van AI als ‘hulpzaak’ speelt een essentiële rol bij het vaststellen van de aansprakelijkheid van de hulpverlener voor schade veroorzaakt door het gebruik van AI. Artikel 6:77 BW bepaalt namelijk dat een tekortkoming in de nakoming van een verbintenis kan worden toegerekend aan de schuldenaar indien deze gebruikmaakt van een ongeschikte hulpzaak. Het is daarom noodzakelijk om te onderzoeken wanneer AI in de medische context kan worden aangemerkt als een hulpzaak, en welke gevolgen dit heeft voor de aansprakelijkheid van de hulpverlener.

De wet stelt in artikel 6:77 BW dat een hulpzaak een ‘zaak’ betreft die de schuldenaar gebruikt bij de uitvoering van een verbintenis, en die ongeschikt blijkt voor dat doel. Het gebruik van een dergelijke ongeschikte hulpzaak leidt tot toerekenbaarheid van een tekortkoming. Dit betekent dat, indien AI wordt beschouwd als een hulpmiddel in de medische behandelingsrelatie, het gebruik van een ongeschikt AI-systeem ervoor kan zorgen dat de tekortkoming in de nakoming van de behandelingsovereenkomst aan de hulpverlener kan worden toegerekend.

Artikel 6:77 BW maakt gebruik van het begrip ‘zaak’ en doelt hierbij op het ‘zaaksbegrip’ in artikel 3:2 BW. Een ‘zaak’ wordt daar omschreven als een voor menselijke beheersing vatbaar stoffelijk object.2 Het gebruik van de term ‘zaak’ roept de vraag op in hoeverre AI, vaak bestaande uit immateriële software of algoritmes, kan worden gekwalificeerd als een ‘zaak’. Betekent dit dat de Da Vinci-Robot als concreet en waarneembare robot wel onder artikel 6:77 BW kan vallen, maar software niet?

De strenge benadering van artikel 3:2 BW is begrijpelijk vanuit goederenrechtelijk perspectief, en voor de coherentie van het Burgerlijk Wetboek zou het goed zijn als het goederen- en het verbintenissenrecht het ‘zaaksbegrip’ op een eenduidige wijze zouden toepassen.3 Nieuwe technologische ontwikkelingen zoals AI compliceren dit echter.

Een eenduidig antwoord op de vraag of software gezien kan worden als ‘zaak’ in de zin van artikel 3:2 BW is moeilijk te geven. Het ligt in de rede om aansluiting te zoeken bij een arrest van de Hoge Raad van 27 april 2012 (Beeldbrigade). De Hoge Raad oordeelt in dit arrest dat het irrelevant is of (standaard)software ten tijde van de aanschaf al dan niet op een drager – zoals een cd-rom – is gevestigd. Ook de wetgever lijkt er niet vies van te zijn om software, uit noodzaak voor het economisch verkeer, te kwalificeren als een zaak in de zin van artikel 3:2 BW. Zo koos de wetgever er bijvoorbeeld voor om, ter implementatie van de inmiddels vervallen rRchtlijn koop op afstand 97/7/EG, de aanschaf van software op afstand in 2001 als koopovereenkomst te kwalificeren. Dit is bijzonder want het toenmalige artikel 7:46a onder b kwalificeerde koop op afstand als ‘de overeenkomst op afstand die een consumentenkoop is. Artikel 7:5 lid 1 BW definieerde consumentenkoop als B2C ‘koop met betrekking tot een roerende zaak’.

Nu software, ondanks zijn ontastbare aard, kan worden gekwalificeerd als een zaak in de zin van artikel 3:2 BW, rijst de vraag of deze software eveneens als ‘hulpzaak’ in de zin van artikel 6:77 BW kan worden aangemerkt. Nu de wet geen concrete aanknopingspunten geeft, is het van belang om te kijken naar de functionele equivalentie van de parlementaire geschiedenis en de Richtlijn medische hulpmiddelen.

2.2 De functionele equivalentie en Parlementaire Geschiedenis

Het toepassen van de leer van de functionele equivalentie houdt in dat er wordt gekeken naar de functies en doelen van bestaande regels, en geanalyseerd wordt of deze ook toegepast kunnen worden bij nieuwe technologieën.

Uit de parlementaire geschiedenis van artikel 6:77 BW blijkt dat de focus ligt op de ondersteunende rol die een zaak vervult bij de uitvoering van een verbintenis. Centraal staat de geschiktheid van de zaak voor het specifieke doel waarvoor deze wordt ingezet.4 Om als een hulpzaak te kwalificeren is het dus van belang dat (a) de AI een ondersteunend karakter heeft en (b) geschikt is voor het doel waar zij voor wordt ingezet.

2.3 De functionele equivalentie en de Richtlijn medische hulpmiddelen

De Richtlijn medische hulpmiddelen (2017/745/EU) (hierna: ‘de Richtlijn’) biedt verdere context voor de kwalificatie van AI als hulpzaak.5 Aangenomen kan worden dat een zaak gekwalificeerd als ‘medisch hulpmiddel’ ook gezien kan worden als een ‘hulpzaak’ in de zin van artikel 6:77 BW. Er is sprake van een medische hulpzaak indien de fabrikant de intentie had om de zaak voor een specifiek medisch doel te gebruiken, zoals genoemd in artikel 1 lid 2 sub A van de Richtlijn. AI die gezien kan worden als ‘een instrument, toestel of apparaat, software, implantaat, reagens, materiaal’ en wordt ingezet voor een van de medische doeleinden zoals opgesomd in artikel 1 lid 2 sub a van de Richtlijn, kan dus gezien worden als een hulpzaak in de zin van artikel 6:77 BW. Overweging 17 van de toelichting bij de Richtlijn benadrukt dit:

‘Verduidelijkt moet worden dat software als zodanig, wanneer die door de fabrikant specifiek bestemd is om te worden gebruikt voor een of meer medische doeleinden als vermeld in de definitie van een medisch hulpmiddel, als medisch hulpmiddel wordt beschouwd, terwijl software voor algemene doeleinden, zelfs wanneer die in een gezondheidszorgomgeving wordt gebruikt, of software die bestemd is voor lifestyle- en welzijnsdoeleinden, geen medisch hulpmiddel is.’

De toelichting bij de Richtlijn benadrukt dat software die specifiek voor medische doeleinden wordt ontwikkeld, zoals diagnostische algoritmes, wél als een medisch hulpmiddel wordt beschouwd, terwijl algemene of lifestyle-software dat niet is. AI die bijvoorbeeld wordt gebruikt voor het bijhouden van het aantal patiënten in een ziekenhuis of ter vermaak wordt ingezet voor ouderen in een verzorgingstehuis, valt daarom niet onder de definitie van een ‘medisch hulpmiddel’.

Door aansluiting bij de Richtlijn kan AI die bestemd is voor medische doeleinden worden aangemerkt als een medisch hulpmiddel en daarmee als hulpzaak in de zin van artikel 6:77 BW. De nadruk ligt op de intentie van de fabrikant en het specifieke doel waarvoor de AI is ontworpen.

2.4 Praktische Toepassingen

De functionele equivalentie en de Richtlijn bieden een grof kader voor de kwalificatie van AI als hulpzaak. In de praktijk betekent dit dat:

- AI in diagnostiek: Diagnostische AI-systemen, zoals het IMAGO-project, die artsen ondersteunt bij het analyseren van medische beelden, als hulpzaak worden beschouwd, omdat zij een ondersteunende rol vervullen en specifiek zijn ontworpen voor medische doeleinden zoals genoemd in artikel 1 lid 2 sub a van de Richtlijn.

- AI in ouderenzorg: Monitoringtools met ingebouwde AI, zoals sensoren die valincidenten detecteren, kunnen ook als hulpzaak worden aangemerkt, mits zij slechts ondersteunend functioneren en niet autonoom beslissingen nemen. Dit geldt niet voor zorgrobots die autonoom optreden en worden ingezet met welzijnsdoeleinden.

- AI in chirurgie: Robots zoals de Da Vinci-robot voldoen aan de criteria voor hulpzaken, zowel vanwege hun fysieke aard als vanwege de ondersteunende rol die zij vervullen bij operaties. Voor de softwarecomponent van deze robots geldt dat aansluiting bij de Richtlijn belangrijk is.

3. Productaansprakelijkheid en AI

Naast contractuele aansprakelijkheid kan ook de productaansprakelijkheid een aanknopingspunt zijn voor het verhalen van schade die ontstaat door het gebruik van AI-systemen in de gezondheidszorg. Deze vorm van kwalitatieve aansprakelijkheid is te vinden in Boek 6, titel 3, afdeling 3 BW en biedt een regime van risicoaansprakelijkheid voor producenten van gebrekkige producten.

3.1 Begrip ‘Product’

De eerste vraag bij de toepassing van dit leerstuk op AI-systemen is die of AI kwalificeert als een product in de zin van artikel 6:187 BW. Volgens deze bepaling omvat een product ‘alle roerende zaken’. Ondanks dat zowel de Richtlijn productaansprakelijkheid en het Burgerlijk Wetboek geen expliciete uitsluiting geven omtrent dit vraagstuk, lijkt het vooralsnog dat (ook) AI onder de regeling valt. De Europese Commissie heeft zich namelijk wel uitgelaten, en verklaard dat – in ieder geval – software beschouwd kan worden als een ‘product’, en valt onder de toepassing van Boek 6, titel 3, afdeling 3 BW.6 Daarnaast wordt aangenomen dat producten waarbij de software ondergeschikt is aan de hoofdzaak en functioneel is voor de werking ervan – zoals bij apparaten die aangestuurd door AI – de regeling van productaansprakelijkheid van toepassing is.7. Dit lijkt aan te sluiten bij de gegeven omstandigheid dat deze producten ook als ‘medisch hulpmiddel’ in de zin van Richtlijn 93/42 EEG betreffende medische hulpmiddelen wordt aangemerkt.

Software en AI die ondergeschikt zijn aan een (medische) hoofdzaak vallen onder de toepassing van Boek 6, titel 3, afdeling 3, BW.

3.2 Gebrek

Een product wordt ingevolge artikel 6:186 lid 1 BW als gebrekkig aangemerkt wanneer het niet de veiligheid biedt die men daarvan mag verwachten. Deze verwachting wordt niet beoordeeld op basis van het perspectief van een individuele gebruiker, maar vanuit het standpunt van het ‘grote publiek’, zoals volgt uit de considerans van de Richtlijn productaansprakelijkheid.

Bij de beoordeling van wat het grote publiek mag verwachten, noemt artikel 6:186 BW drie relevante factoren: de presentatie van het product, het redelijkerwijs te verwachten gebruik en het tijdstip waarop het product in het verkeer is gebracht. Daarnaast spelen aanvullende omstandigheden, zoals vastgesteld in jurisprudentie, een rol. Voor AI-systemen in de gezondheidszorg lijken de volgende factoren bijzonder relevant.

3.3 Nut en proportionaliteit

Allereerst kan gekeken worden naar het nut van de AI, mede afgezet tegen de nadelen, de ernst van het letsel, de frequentie van het optreden van nadelen en het bestaan van alternatieven. De Hoge Raad heeft bepaald dat een product als gebrekkig kan worden aangemerkt wanneer de ernst van mogelijke schadelijke bijwerkingen en de kans op bijwerkingen niet gerechtvaardigd kunnen worden. Dit geldt vooral wanneer de ernst van de ziekte of kwaal die het product beoogt te genezen of te bestrijden niet in verhouding staat tot de effectiviteit van het product, de wijze van productinformatie en de (potentiële) schadelijkheid van alternatieve producten, HR 30 juni 1989, NJ 1990, 652, (Halcion-arrest)).

Voor het vestigen van productaansprakelijkheid wegens het gebruik van (gebrekkige) AI is het dus belangrijk dat de (potentiële) schade die de AI kan veroorzaken, wordt afgewogen tegen de ernst van het incident of de aandoening en de mogelijke alternatieven. AI zal eerder als gebrekkig worden beschouwd wanneer de schade die het veroorzaakt en de kans daarop, niet in verhouding staan tot de ernst van de aandoening en er veiligere alternatieven beschikbaar zijn, zoals menselijke tussenkomst.

3.4 Prijs van het product

De prijs kan aanvullende veiligheidsverwachting scheppen, maar elk product – ongeacht de prijs – moet een basisniveau van veiligheid bieden.

3.5 Aard van het product

Voor medische hulpmiddelen, waaronder AI-toepassingen, gelden bijzonder hoge veiligheidseisen. Dit volgt – onder meer – uit het arrest Boston Scientific Medizintechnik, waarin het hof vaststelde dat de kwetsbaarheid van patiënten vraagt om strenge veiligheidsnormen (HvJ EU 5 maart 2015, ECLI:EU:C:2015:148, Boston Scientifici Medizintechnik GmbH t./ AOK Sachsen-Anhalt – Die Gesundheitskrasse en Betriebskrankenasse RWE. Deze eisen gelden ook voor AI als medisch hulpmiddel, gelet op haar rol en classificatie binnen de gezondheidszorg.

3.6 Tijdstip van in het verkeer brengen en ‘state of the art’

De beoordeling van gebrekkigheid vindt plaats op basis van de technologische standaarden die golden op het moment dat het product in het verkeer werd gebracht. AI-systemen die op dat moment voldeden aan de toenmalige normen en standaarden worden niet als gebrekkig beschouwd, zelfs als latere ontwikkelingen aantonen dat ze verouderd zijn.

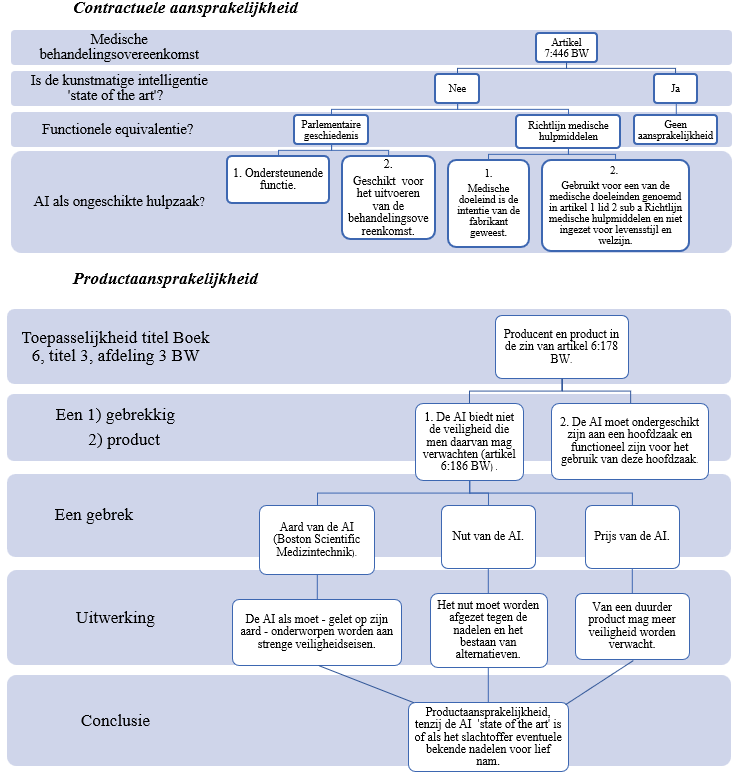

Schematische tussenconclusie

Het juridische kader, zoals hiervoor uiteen is gezet is complex, omvangrijk en zeer gelaagd. Om deze juridische lagen inzichtelijk en beeldend te maken is dit in de volgende schema’s opgenomen als tussenconclusie. Deze schema’s worden hierna toegepast op de praktijk.

4. AI in de ouderenzorg, diagnostiek en chirurgie

Zoals eerder besproken speelt AI een steeds grotere rol binnen de zorg. Het gebruik van AI manifesteert zich voornamelijk in de domeinen ouderenzorg, diagnostiek en chirurgie. Ondanks het ontbreken van specifieke wetgeving bieden contractuele aansprakelijkheid en productaansprakelijkheid belangrijke aanknopingspunten voor het verhalen van schade veroorzaakt door het gebruik van een gebrekkige AI.

4.1 AI in de ouderenzorg

Meerdere internationale (literatuur)studies tonen aan dat de inzet van AI in de ouderenzorg een breed scala aan kansen biedt, zoals efficiëntere en meer persoonsgerichte zorg.8 Het is dan ook niet verbazingwekkend dat zorgrobots in toenemende mate in het verzorgingstehuis zijn te vinden. Er zijn verschillende soorten zorgrobots, zo zijn er robots die ondersteunen bij fysieke taken zoals een persoon uit bed tillen, helpen met eten of juist sociaal zijn ingesteld en zorgen voor dagbesteding. Sociale zorgrobots worden onder andere in zorginstellingen ingezet om te communiceren met eenzame ouderen, herinneren vergeetachtige bejaarden aan hun medicatie of helpen dementerende ouderen met het trainen van hun geheugen.

Maar, wat als een zorgrobot door een onbekende fout ineens onvoldoende draagkracht blijkt te hebben, hierdoor uitvalt of een storing krijgt en een corpulente patiënt laat vallen. Kan de hulpverlener die gebruikmaakte van deze hulpzaak aansprakelijk worden gesteld, of ligt het voor de patiënt eerder voor de hand om de producent aan te spreken?

Omdat het in deze situatie een medische hulpzaak betreft – een zorgrobot die de hulpverlener ondersteunt bij de uitvoering van de behandelingsovereenkomst – moet eerst gekeken worden naar de ‘state of the art’. Indien blijkt dat de zorgrobot ten tijde van het gebruik ‘state of the art’ was, dan brengt de ongeschiktheid van de robot geen tekortkoming mee. Indien de benadeelde kan aantonen dat de schade is ontstaan door een AI-systeem dat, gemeten naar de stand van de techniek ten tijde van het gebruik, ongeschikt was, dan is er sprake van een tekortkoming. Vervolgens moet de benadeelde aantonen dat deze tekortkoming toerekenbaar is aan de hulpverlener. De tekortkoming is toerekenbaar indien de hulpverlener gebruik heeft gemaakt van een ‘hulpzaak’.

Of de hulpverlener voor de ongeschiktheid van de zorgrobot aansprakelijk kan worden gesteld, hangt dus heel erg af van de soort zorgrobot. Ervan uitgaande dat de zorgrobot ten tijde van gebruik geen ‘state of the art’ is, zal betoogd kunnen worden dat de zorgrobot die puur ziet op vermaak van de patiënten geen ondersteunende rol heeft. De robot functioneert zelfstandig en krijgt geen sturing van de hulpverlener. Daarnaast wordt de robot ook niet ingezet voor een van de toepasselijke medische doeleinden: diagnose, preventie, monitoring, voorspelling, prognose, behandeling of verlichting van ziekte. De zorgrobot is derhalve niet te kwalificeren als een ‘hulpzaak’ in de zin van artikel 6:77 BW, en een eventuele tekortkoming wegens de ongeschiktheid van de zorgrobot zal niet toerekenbaar zijn. Dit is niet het geval bij de zorgrobot die de patiënt uit bed tilt. Deze zorgrobot kent een puur ondersteunende functie en wordt aangestuurd door de hulpverlener. Door dit ondersteunende en hulpverlenende karakter kan de zorgrobot worden gekwalificeerd als hulpzaak in de zin van artikel 6:77 BW. Al met al zal de benadeelde in de meeste gevallen moeten aanvoeren dat de kunstmatige AI in de ouderenzorg – bij de uitvoering van de behandelingsovereenkomst – een ondersteunende rol heeft. Indien de benadeelde dit niet kan aantonen kan de AI niet als (ongeschikte) hulpzaak worden aangemerkt, en is de tekortkoming in de nakoming niet – via artikel 6:77 BW – toerekenbaar. De benadeelde kan vervolgens wel kijken of hij zijn schade kan verhalen op de producent van de AI.

Als het slachtoffer de producent aansprakelijk wil stellen dient hij aan te voeren dat de zorgrobot een product is in de zin van artikel 6:187 BW en dit product gebrekkig is. Producten waarbij de software ondergeschikt is aan de hoofdzaak en functioneel is voor de werking ervan, de regeling van productaansprakelijkheid van toepassing is (zie noot 7). In het voorbeeld van de zorgrobot is dit het geval. De zorgrobot worden namelijk aangestuurd door een geprogrammeerd softwaresysteem, en deze software is – in tegenstelling tot puur planmatige AI-systemen – ondergeschikt en functioneel voor de werking.

Daarnaast moet het product een gebrek kennen. Of dit het geval is, verschilt natuurlijk per casus, maar de zorgrobot is in ieder geval gebrekkig indien zij niet de veiligheid bieden die de patiënten daarvan mogen verwachten. Wat de patiënten van de zorgrobot mogen verwachten moet getoetst worden aan een aantal omstandigheden.

Er moet gekeken worden naar het nut van de zorgrobot, afgewogen tegen de nadelen, de ernst van het letsel, de frequentie van nadelen en het bestaan van alternatieven. Voor deze casus is het zeer relevant dat de zorgrobot eerder als ‘gebrekkig’ wordt beschouwd als er alternatieven bestaan. Indien de werkzaamheden van de zorgrobot ook vervangen kunnen worden door menselijk handelen, zal deze zorgrobot dus (eerder) als een gebrekkig product worden gekwalificeerd. Aan de andere kant gaat dit slechts op indien de kans op schade zeer laag is. Anders gezegd, het feit dat de werkzaamheden van de robot vervangbaar zijn voor menselijk handelen, is slechts een indicatie van gebrekkigheid als het optreden van de robot enig risico met zich meebrengt.

Daarnaast is de aard van het product van belang. Indien de zorgrobot – dit verschilt per soort robot – een medisch product is met een ongebruikelijk potentieel om schade aan de persoon te veroorzaken, geldt een bijzonder hoog veiligheidsniveau. Indien de zorgrobot niet aan deze veiligheidseisen voldoet, dan is hij gebrekkig. Dit volgt uit de zaak Boston Scientific. Het blijft discutabel in hoeverre de zorgrobot als een ‘medisch hulpmiddel met een verhoogd veiligheidsrisico’ gekwalificeerd kan worden. Er bestaat nog geen rechtspraak omtrent de toepassing van Boston Scientifix op AI, maar toepassing van Boston Scientifix op zorgrobots ligt mijns inziens niet in de rede. Immers speelden in deze zaak pacemakers en implanteerbare cardioverter-defibrillatoren een rol. Volgens het hof kennen ‘dit soort medische hulpmiddelen’ een verhoogd veiligheidsrisico. Zorgrobots kunnen niet gelijkgesteld worden met pacemakers, implanteerbare cardioverter-defibrillatoren en andere cruciale medische hulpmiddelen waarvan de gezondheid van de patiënt afhankelijk is.

Geconcludeerd kan worden dat de mogelijkheid tot het vestigen van aansprakelijkheid nauw samenhangt met de werkzaamheden, het gebruik en het doel van de zorgrobot.

4.2 AI in de diagnostiek

AI biedt ook de diagnostiek enorme mogelijkheden. Zo kunnen AI-systemen bijvoorbeeld grote hoeveelheden gegevens snel analyseren. Hierdoor kan AI klinische besluitvorming versnellen en verbeteren door relevante informatie te halen uit enorme hoeveelheden beschikbare data.9 De kracht van AI om ziekten in een vroeg stadium te diagnosticeren, werd benadrukt tijdens de coronapandemie. Een AI-algoritme dat informatie van thorax computertomografie (CT) combineerde met laboratoriumtesten, blootstellingsgeschiedenis en klinische symptomen, bleek net zo goed in staat COVID-19-patiënten te identificeren als een ervaren thoraxradioloog. Opvallend was dat dit algoritme radiologen overtrof in het herkennen van patiënten die positief testten via reverse transcriptase-polymerase chain reaction (RT-PCR), maar bij wie resultaten van de CT-scan in een vroeg stadium van de ziekte nog normaal waren.10 Daarnaast kan AI worden gebruikt voor het verbeteren van ziekteherkenning tijdens de verwerking van diagnostische gegevens. Onderzoek toont aan dat AI een bijdrage kan leveren bij het (sneller) opsporen van ziekten en een efficiëntere inzet van diagnostiek.11 AI is namelijk in staat om grote volumes aan medische beelden te analyseren. Zelfs ziektes die moeilijk te detecteren zijn voor artsen, kunnen door AI worden gedetecteerd. Het vermogen om subtiele afwijkingen te herkennen kan niet alleen leiden tot verbeterde patiëntresultaten, maar ook tot aanzienlijke kostenbesparingen. Zo blijkt uit onderzoek dat het vroegtijdig diagnosticeren en behandelen van verschillende vormen van kanker de gezondheidszorg een kostenbesparing van wel vijftig procent kan opleveren.12

Om succesvol te zijn moet de inzet van AI in de diagnostiek goed worden begeleid door de patholoog. Hiervoor lijkt te zijn vereist dat de hulpverlener een leidende rol blijft houden. Maar, wat als er schade ontstaat doordat de AI verkeerd is ingesteld en hierdoor tot een verkeerde conclusie/diagnose komt? Kan de benadeelde de hulpverlener die gebruikmaakt van de AI-systemen, of de producent van de AI aansprakelijk stellen? In deze paragraaf zullen aan de hand van een praktijkvoorbeeld deze vraagstukken worden beantwoord. Als praktijkvoorbeeld is gekozen voor de toepassing van AI bij de opsporing van kanker. Denk hierbij aan een bevolkingsonderzoek naar borstkanker, waarbij vrouwen een röntgenfoto van hun borst laten maken. In sommige gevallen kan een afwijking door het menselijk ook gekwalificeerd worden als tumor, maar in veel gevallen is de afwijking te klein om al over een tumor te spreken. De vraag is dan of een verwijzing naar het ziekenhuis wel nodig is. AI kan dan een aanvulling zijn op deze screening.

Indien er schade ontstaat door het gebruik van de (gebrekkige) screeningssoftware, kan de benadeelde – onder bepaalde – omstandigheden de hulpverlener aanspreken. Voor de beoordeling van de aansprakelijkheid wegens een medische (hulp)zaak – screeningssoftware die kanker in een vroegtijdig stadium aantoont – moet er allereerst naar de ‘state of the art’ gekeken worden. Indien de benadeelde kan aantonen dat de screeningssoftware ten tijde van gebruik al ongeschikt was is er een tekortkoming; deze tekortkoming moet dan nog wel worden toegerekend aan de hulpverlener die gebruikmaakte van de screeningssoftware.

Deze tekortkoming kan op grond van artikel 6:77 BW worden toegerekend indien de hulpverlener gebruikmaakt van een ‘hulpzaak’. Ondanks dat ‘hulpzaak’ oorspronkelijk verwijst naar een roerende – voor menselijk handelen vatbare – zaak, kan AI onder sommige omstandigheden ook als hulpzaak in de zin van artikel 6:77 BW worden beschouwd. Voor beantwoording van de vraag of de screeningssoftware kan worden beschouwd als een ‘hulpzaak’ kan aansluiting worden gezocht bij de Richtlijn medische hulpmiddelen. Volgens artikel 1 lid 2 sub a van deze richtlijn is software dat wordt gebruikt voor (medische) diagnose een ‘medisch hulpmiddel’. Uit de literatuur volgt dat dit soort ‘medische hulpmiddelen’ als hulpzaak in de zin van artikel 6:77 BW worden beschouwd, mits de fabrikant de intentie had de AI voor een specifiek medisch doel te gebruiken. Dit is in deze casus het geval, de software wordt ten slotte ingezet voor een diagnose en kan voor geen enkel ander (medisch) doel worden ingezet. De software kan derhalve als een hulpzaak worden gekwalificeerd en de tekortkoming kan aan de hulpverlener worden toegerekend indien deze hulpzaak gebrekkig is.

Mocht de benadeelde geen beroep kunnen doen op artikel 6:74 BW, kan hij proberen de producent van de screeningssoftware aan te spreken. Hij zal dan de fabrikant van de screeningssoftware moeten aanspreken, en mocht deze onbekend zijn de leverancier van de software. Hierna dient hij aan te tonen dat de software een ‘product’ in de zin van artikel 6:185 BW is. De Europese Commissie heeft aangegeven software te beschouwen als een dergelijk product. Dit product moet vervolgens een gebrek kennen. De benadeelde zal moeten vaststellen dat het product niet de verwachte veiligheid biedt. Dit wordt bepaald door verschillende factoren. Artikel 6:186 BW geeft een niet limitatieve lijst en deze wordt aangevuld door de rechtspraak. Voor deze casus is het van belang dat de schade die kan ontstaan door een gebrekkige software – een foute diagnose – groot is. De ernst van deze schade, en de kans dat deze schade intreedt, moet worden afgewogen tegen de ernst van de aandoening en eventuele veiligere alternatieven. De productaansprakelijkheid hangt dus enorm af van de aard van de ziekte die de software zou diagnosticeren.

Zo zal bijvoorbeeld de onjuiste diagnose inhoudende dat kanker afwezig is, terwijl dit niet het geval is, veel (potentiële) schade met zich meebrengen. De patiënt kan door de foutieve diagnose – in de meeste gevallen – niet (meer) schadebeperkend handelen. Dit moet worden afgewogen tegen de (eventueel aanwezige) mogelijkheid om de kanker door middel van menselijk handelen te diagnosticeren. Indien dit het geval is, is de software gebrekkig en kan de productaansprakelijkheid worden gevestigd. Uitzondering hierop is de software die op het tijdstip waarop het in het verkeer werd gebracht ‘state of the art’ was, waarbij eventuele bekende nadelen van het gebruik ervan voor lief werden genomen.

4.3 AI bij chirurgisch optreden

Wellicht de meest indrukwekkende vorm van AI is te vinden binnen de chirurgie. In deze paragraaf wordt het gebruik van een AI-systeem, ontwikkeld voor robotgeassisteerde prostaatkankeroperaties, als voorbeeld besproken. Operaties om prostaatkanker te behandelen zijn afgelopen jaren steeds vaker uitgevoerd met behulp van een robot en een 3D-beeldscherm. Sinds kort ontwikkelt het LUMC AI die de artsen hierbij helpt.

Voorafgaand aan de ingreep krijgt de patiënt een kleine hoeveelheid radioactieve stof toegediend via een infuus. Deze stof helpt om tumoruitzaaiingen in de lymfeklieren zichtbaar te maken. Tijdens de operatie maakt de chirurg gebruik van een kleine detector, een zogenaamde ‘gammasonde’, om het radioactieve signaal in de klieren te lokaliseren en om te zetten in een 3D-beeld. Omdat dit slechts een kijkoperatie is, wordt de gammasonde via een klein gaatje in de buikwand ingebracht. De chirurg houdt de sonde niet zelf vast, dit doet een robot voor hem. De chirurg bestuurt de robotinstrumenten met joystick, terwijl hij de voortgang van de ingreep rechtstreek op een 3D-beeldscherm volgt.13

Het LUMC heeft een onderzoek verricht, geleid door Samaneh Azargoshasb, naar het gebruik van AI in combinatie met de videobeelden om de positie van de sonde tijdens de ingreep te volgen. Door het trainen van het AI-systeem met behulp van deze beelden kon het systeem informatie verzamelen over de bewegingen van de sonde, inclusief de snelheid en eventuele schokken. Na de afloop van de kijkoperatie kunnen de chirurgen het AI-systeem gebruiken om een gedetailleerde analyse uit te voeren en kan de opvolgende chirurgische ingreep nauwkeuriger worden uitgevoerd. De ontwikkeling gaat echter verder. Nu kijken de chirurgen nadat de operatie is uitgevoerd naar de video-analyse, maar het doel is om de chirurg tijdens de operatie door de AI van feedback te voorzien. Mocht het ziekenhuis een dergelijk systeem introduceren, kan de chirurg aansprakelijk worden gesteld voor schade die ontstaat door de foutieve werking van het AI-systeem? Wat als de gammasonde een afwijking heeft, of onjuiste informatie doorgeeft aan de behandelend chirurg.

Ook bij het vestigen van aansprakelijkheid wegens het gebruik van AI tijdens chirurgisch optreden is het voor het slachtoffer van belang om de – afwezigheid van – ‘state of the art’ vast te stellen. Immers, wordt in deze casus ook gebruikgemaakt van een – achteraf gezien ongeschikte – (medische) hulpzaak. Dit betekent dat de benadeelde allereerst moet aanvoeren dat de hulpzaak ten tijde van gebruik niet ‘state of the art’ was. Indien dit betoog slaagt, dient de benadeelde vervolgens aan te tonen dat de tekortkoming in de nakoming toerekenbaar is. Het gebruik van de ongeschikte AI komt voor rekening van de hulpverlener indien aan artikel 6:77 BW is voldaan. Hiervoor is vereist dat de AI gekwalificeerd kan worden als ‘hulpzaak’.

Het slachtoffer zal moeten aantonen dat de AI een ondersteunende rol heeft bij de uitvoering van de behandelingsovereenkomst. Hierbij kunnen de bewijsrechtelijke regels en aanvullingen – zoals de omkeringsregel en de verzwaarde stelplicht – uit het medische aansprakelijkheidsrecht hem ondersteunen. Daarnaast kan er gekeken worden naar de intentie van de fabrikant. De fabrikant moet de intentie hebben gehad om de AI op de markt te hebben gebracht zodat zij gebruikt zou worden voor een van de volgende specifieke medische doeleinden: diagnose, preventie, monitoring, voorspelling, prognose, behandeling of verlichting van ziekte. Deze vorm van AI is een mooi representatief van een AI-systeem, met een pure ondersteunende rol bij de uitvoering van de behandelingsovereenkomst. Tijdens de (kijk)operatie is het nog steeds de arts die de patiënt opereert – en derhalve uitvoering geeft aan de behandelingsovereenkomst – de gammasonde helpt hem hierbij door de arts tijdens de operatie van feedback te voorzien. De AI kan als hulpzaak worden gekwalificeerd in de zin van artikel 6:77 BW, en een eventuele tekortkoming is derhalve toerekenbaar.

Deze conclusie lijkt kenmerkend voor de aansprakelijkheid wegens het gebruik van AI bij chirurgisch optreden. Immers, zal AI bij operaties vaak een ondersteunende rol hebben. Al zou de AI een grote rol spelen bij operaties en veel autonomie hebben, zal het uiteindelijk de arts zijn die ‘robot’ inschakelt en afstelt. Mijn vermoeden is dan ook sterk dat de AI die worden gebruikt bij chirurgische ingrepen snel als hulpzaak gekwalificeerd kunnen worden. In de meeste gevallen is het de arts die de AI beheerst, en in de meeste gevallen kent de AI een ondersteunende functie. Uiteindelijk hangt dit (natuurlijk) wel af van de omstandigheden van het geval.

Voordat de productaansprakelijkheid gevestigd kan worden in een casus zoals deze, is allereerst van belang dat er een ‘producent’ is. Als producent wordt beschouwd de fabrikant van een onderdeel, grondstof of eindproduct, maar ook degene die zich als producent presenteert of het product in de EU invoert voor commerciële doeleinden. Ervan uitgaande dat er een producent aanwezig is, dient er vervolgens ook sprake te zijn van een ‘product’. In deze casus maakt de arts gebruik van een roerende zaak, waardoor er de facto sprake is van een ‘product’.

Daarna moet beoordeeld worden of het product – de gammasonde – wel de verwachte veiligheid biedt. Dit wordt bepaald door verschillende factoren, waaronder de aard van het product. Uit de zaak Boston Scientific Medizintechnik volgt dat de kwetsbare situatie van hulpbehoevenden maakt dat de gammasonde moet voldoen aan zeer strenge veiligheidseisen. Gesteld kan worden dat de gammasonde ervoor zorgt dat er (indirect) schade bij de patiënt ontstaat, en derhalve niet de verwachte veiligheid biedt. Anderzijds lijkt deze redenering onterecht, het is namelijk niet de gammasonde die schade veroorzaakt aan het lichaam. De schade vloeit voort uit de uiteindelijke (verkeerde) behandeling. Het ligt in de rede om de uitspraak Boston Scientific slechts toe te passen op medische hulpzaken – en AI die als zodanig gekwalificeerd worden – die zelfstandig schade veroorzaken aan de patiënt. Immers, de ‘medische hulpmiddelen’ in de zaak Boston Scientific betroffen een Pacemaker en een implanteerbare cardioverter-defibrillatoren (ICD). Deze gebrekkige zaken konden rechtstreeks schade aanrichten, dit kan de gammasonde – in de geschetste casus – niet. Oftewel, gelet op Boston Scientific dienen de medische hulpmiddelen (directe) schade aan te richten aan het slachtoffer. Dit is in deze casus niet het geval. Toepassing van deze zaak ligt in dan ook niet in de rede.

Toch, bieden de wet en rechtsspraak nog meer aanknopingspunten voor productaansprakelijkheid. Zo kan er ook gekeken worden naar de prijs en het nut van het product. Betreft het nut van de gammasonde dient zij te worden afgezet tegen de nadelen en de mogelijke ernst van het letsel. Daarnaast dient er gekeken te worden naar alternatieven. Een beroep op deze regel zal eerder slagen. Voornamelijk gelet op het feit dat momenteel AI bij de hedendaagse behandeling pas na de operatie wordt ingezet, en deze werkwijze (goed) blijkt te werken. De ernst van het letsel hier tegenover afgewogen, lijkt onevenredig. Anderzijds kan worden beargumenteerd dat de kans dat de sonde tijdens de kijkoperatie verkeerde gegevens doorgeeft zeer klein is, en het gebruik derhalve weinig nadelen kent.

Het is (nog) maar de vraag hoe de rechter met een vraagstuk als deze omgaat, en welke kant hij op buigt.

AI zal als gebrekkig moeten worden beschouwd indien de schade die het veroorzaakt, en de kans daarop, niet in verhouding staan tot de ernst van de aandoening en er veiligere alternatieven beschikbaar zijn, zoals menselijke tussenkomst. Aangezien de kans op schade in een casus als deze onduidelijk is – de AI is nog niet op de markt gebracht – valt er (nog) geen eenduidig antwoord te geven.

4.4 aanvullende voorbeelden

Orbita is een AI-platform dat hulpverleners – onder anderen – helpt bij het beheren van patiëntafspraken en administratieve taken zoals het bijhouden van medische dossiers. Orbita kan in deze vorm als AI niet worden gekwalificeerd als hulpzaak in de zin van artikel 6:77 BW omdat zij geen ondersteunde rol geeft aan de uitvoering van de behandelingsovereenkomst. Het beheren van patiëntafspraken door AI is een ‘handigheidje’ dat de hulpverlener in zijn werk kan ondersteunen. Zij geeft echter niet een ondersteunende rol in de uitvoering van de behandelingsovereenkomst die de patiënt met het verzorgingstehuis heeft gesloten. Mocht Orbita ongeschikt blijken te zijn en schade toebrengen aan patiënten kan deze tekortkoming niet aan de hulpverlener dan wel het verzorgingstehuis worden toegerekend op grond van artikel 6:77 BW.

Ondanks dat Orbita geen fysieke zaak is, is de regeling omtrent productaansprakelijkheid toch van toepassing. De Europese Commissie heeft software ten slotte als product gekwalificeerd, waarop Boek 6, titel 3, afdeling 3 BW op van toepassing is. Mijns inziens leent het arrest Boston Scientific zich niet voor de beoordeling van Orbita. Het doel van Orbita – een handigheidje voor de hulpverlener – verschilt namelijk volledig met het doel van een pacemakers. Hierdoor zal de er gekeken moeten worden naar het nut van de software, de mogelijke nadelen en het bestaan van alternatieven. Mijns inziens lijkt Orbita dusdanig weinig nadelen te hebben en is het alternatief – bijvoorbeeld een secretaresse/roostermaker – zo ‘nadelig’ dat productaansprakelijkheid niet gevestigd kan worden. Het gebruik van Orbita kan de hulpverlener veel opleveren en kosten besparen, daar waar de risico’s zo goed als nihil lijken te zijn.

PathAI ondersteunt en verbetert pathologische diagnosen waarbij de hulpverlener (de patholoog) een stukje weefsel van de patiënt onderzoekt. De software kan afwijkingen detecteren die de patholoog kan missen. PathAI kan als hulpzaak worden gekwalificeerd omdat zij allereerst een duidelijke ondersteunende functie heeft bij de uitvoering van de medische behandelingsovereenkomst, namelijk het verrichten van onderzoek naar een eventueel aanwezige ziekte. Daarnaast wordt PathAI ingezet voor een van de medische doeleinden (diagnose) zoals genoemd artikel 1 lid 2 sub a van de Richtlijnen medische hulpmiddelen. Indien PathAI schade veroorzaakt en er sprake is van een tekortkoming in de nakoming, kan deze tekortkoming aan de hulpverlener worden toegerekend op grond van artikel 6:77 BW.

PathAI moet als zogenaamde ‘screeningssoftware’ worden beschouwd als product in de zin van artikel 6:185 BW. De patiënt zal moeten aantonen dat deze software een gebrek heeft en dat zij niet de veiligheid heeft die men ervan mag verwachten. Hierbij moet er rekening worden gehouden dat de AI moet worden onderworpen aan strenge veiligheidseisen en dat het nut moet worden afgezet tegen de nadelen en het bestaan van alternatieven. Daarnaast zijn ook de kans dat er schade bij een verkeerde diagnose ontstaat en de ernst van deze schade relevant. Of er sprake is van een ‘gebrek’ verschilt dus per onderzoek. Gaat het bijvoorbeeld om een periodiek onderzoek naar borstkanker, of een eenmalige diagnose. Een eventuele misstap kan ten slotte worden gecorrigeerd bij een tweede controleafspraak. Hiertegenover staat weer dat de software aan strenge veiligheidseisen moet voldoen, indien de patiënt kan aantonen dat de software niet voldoet aan deze veiligheidseisen zal het product alsnog gebrekkig zijn.

Desire (Discharge aftEr Surgery usIng aRtificial intElligence)

Desire is AI-software dat artsen en verpleegkundigen van het Erasmus MC helpt met het voorspellen van hoe lang een patiënt opgenomen moet blijven na een operatie. Het model voorspelt op dag twee na de operatie of een patiënt het ziekenhuis veilig kan verlaten, en/of wat een volgende passende opvangplek voor hem is. Hierdoor blijven patiënten niet langer dan nodig in het ziekenhuis, en heeft het ziekenhuis eerder een ziekenhuisbed vrij. Echter, zoals bij elk van deze voorbeelden kan deze werkwijze ook nadelig uitpakken voor de patiënt. Want, wat als de software van het programma niet up-to-date is en een verkeerde voorspelling leidt tot complicaties en een eventuele heropname?

De AI-software kan worden gekwalificeerd als een hulpzaak. DESIRE heeft een ondersteunende functie bij het uitvoeren van een behandelingsovereenkomst. Immers, onderdeel van de behandeling is het bepalen wanneer de patiënt na een (chirurgische) operatie het ziekenhuis kan verlaten. Daarnaast valt zij onder het medische deeleind ‘voorspelling’ zoals genoemd in artikel 1 lid 2 sub a van de Richtlijn medische hulpmiddelen. Indien de DESIRE schade veroorzaakt – door een verkeerde voorspelling – en er sprake is van een tekortkoming in de nakoming, kan deze tekortkoming aan de hulpverlener worden toegerekend op grond van artikel 6:77 BW.

DESIRE wordt – aangezien het gaat om software – als een product in de zin van artikel 6:185 BW beschouwd. Voor het vestigen van productaansprakelijkheid is vereist dat de patiënt kan aantonen dat de AI een ‘gebrek’ kent. Dit betekent dat hij moet aanvoeren waarom de AI niet de veiligheid verschaft die men ervan mag verwachten. Hij kan hierbij verschillende punten aanvoeren. Zo moet het nut worden afgezet tegen de nadelen en het bestaan van alternatieven. Daarnaast zijn ook de kans dat er schade ontstaat bij een verkeerde voorspelling en de ernst van de schade voortvloeiende uit deze verkeerde voorspelling relevant. Er kan een sterk betoog gevoerd worden dat een beroep op productaansprakelijkheid slaagt. Immers, zijn er alternatieven en het nadeel – het niet kunnen inzetten van een tijdbesparend middel – van deze alternatieven lijken niet groot. Daarnaast zijn – ondanks dat de kans waarschijnlijk klein is – de gevolgen van een verkeerde voorspelling zeer groot.

5. Conclusie

De toepassing van artificiële intelligentie (AI) in de gezondheidszorg biedt zowel voordelen als uitdagingen en (medische) risico’s. Hoewel AI bijdraagt aan efficiëntere zorg en betere uitkomsten, leidt het gebruik ervan ook tot complexe juridische vragen over het vestigen van medische aansprakelijkheid en het toerekenen van de tekortkoming in de nakoming van de behandelingsovereenkomst. In dit artikel is onderzocht hoe contractuele aansprakelijkheid en productaansprakelijkheid kunnen worden toegepast op het gebrekkig optreden van een AI-systeem in de gezondheidszorg.

5.1 Contractuele aansprakelijkheid

Medische hulpverleners kunnen contractueel aansprakelijk worden gesteld op grond van artikelen 6:74 jo. 6:77 BW wanneer AI als een hulpzaak wordt gekwalificeerd als hulpzaak en het gebruik ervan leidt tot een tekortkoming in de nakoming van de behandelingsovereenkomst. De volgende criteria zijn hierbij van belang:

- Er is een medische behandelingsovereenkomst.

- De AI is geen ‘state of the art’.

- De AI kan gekwalificeerd worden als hulpzaak ex. artikel 6:77 BW.

- aansluiting bij de parlementaire geschiedenis, de AI kent een ondersteunende functie en is geschikt voor het uitvoeren van de behandelingsovereenkomst;

- aansluiting Richtlijn medische hulpmiddelen, het medische doel is de intentie van de fabrikant geweest en de AI is gebruikt voor een van de medische doeleinden genoemd in artikel 1 lid 2 sub a Richtlijn medische hulpmiddelen.

iv. Aan de overige vereisten van artikel 6:74 BW zijn voldaan.

De combinatie van deze factoren maakt duidelijk dat contractuele aansprakelijkheid voor hulpverleners sterk afhankelijk is van de geschiktheid van de AI en de omstandigheden van het gebruik. Zo is bij diagnostische toepassingen de mate waarin AI ondersteuning biedt bij medische besluitvorming van groot belang. In de ouderenzorg heeft AI doorgaans een ondersteunende functie, maar kan ook worden ingezet voor andere doeleinden, zoals vermaak. Of een AI-systeem – een zorgrobot – als hulpzaak kan worden gekwalificeerd en een tekortkoming aan de hulpverlener kan worden toegerekend, hangt sterk af van de specifieke rol – vermaak of ondersteuning – die de AI binnen het verzorgingstehuis vervult. Bij chirurgische toepassingen blijft de hulpverlener doorgaans in controle en heeft de AI minder autonomie, waardoor deze sneller als hulpzaak wordt aangemerkt. Toch zullen nieuwe juridische vraagstukken ontstaan wanneer AI zelfstandig opereert en de arts slechts verantwoordelijk is voor de initiële afstelling van het systeem.

5.2 Productaansprakelijkheid

De producent van de AI kan aansprakelijk worden gesteld op basis van productaansprakelijkheid indien de AI – gelet op de aard en het nut van het product – een gebrek kent. Toepassing hiervan op praktijkvoorbeelden toont aan dat mogelijkheid tot het aansprakelijk stellen sterk afhankelijk is van de aard van de AI, de zorgcontext en de vraag of de AI enkel als hulpmiddel wordt ingezet of als zelfstandig opererend systeem. Aan de volgende criteria dienen te worden voldaan:

- Er moet sprake zijn van een producent in de zin van artikel 6:178 BW.

- Er moet sprake zijn van een product in de zin van artikel 6:178 BW.

- Dit product dient gebrekkig te zijn, hierbij dient gekeken te worden naar:

- de AI voldoet – gelet op zijn aard – niet aan de strenge veiligheidseisen voortvloeiende uit Boston Scientific Medizintechnik;

- het nut van de AI, en dit nut moet worden afgezet tegen de nadelen en het bestaan van alternatieven;

- de prijs van de AI is relevant, en van een duurder product mag meer veiligheid worden verwacht.

iv. De AI was geen 'state of the art' of de patiënt nam (eventuele) bekende nadelen voor lief.

5.3 afsluitend en eigen beschouwing

De opkomst van AI in de gezondheidszorg biedt enorme kansen en voordelen. Van vermaak voor de ouderen tot aan efficiëntie in het ziekenhuis. Van betere diagnosen tot aan preciezere operaties. Deze technologische vooruitgang neemt – zoals vele maatschappelijke en technologische ontwikkelingen – juridische vraagstukken met zich mee. Deze (aansprakelijkheids)vraagstukken heb ik in deze bijdrage geplaatst binnen een bestaand juridische kader, maar specifieke wetgeving lijkt noodzakelijk. Want ondanks, dat het vestigen van contractuele – en productaansprakelijkheid mogelijk is, blijft er veel onduidelijk. Zoals de vraag: wanneer is AI ‘state of the art’? Of wanneer levert het gebruik van een schadeveroorzakende AI een tekortkoming in de nakoming op? En hoe moet huidige jurisprudentie zoals HR Miragelplombe, HR PIP-implantaat en de uitspraak in Boston Scientific worden toegepast op AI? Nieuwe wetgeving zal dergelijke vragen moeten beantwoorden en ziekenhuizen en slachtoffers duidelijke juridische kaders moeten verschaffen met betrekking tot het medische aansprakelijkheidsrecht.

AI zal zich verder ontwikkelen, en deze vooruitgang is onvermijdelijk. De vraag is of we deze ontwikkeling moeten omarmen of vrezen. Het lijkt in de aard van de mens te liggen om terughoudend en angstig te zijn tegenover nieuwe en onbekende technologieën, dit geldt ongetwijfeld ook voor AI. Overheidsinstanties zullen alert moeten blijven op technologische ontwikkelingen van AI in de gezondheidszorg en, waar nodig, optijd en adequaat ingrijpen met passende wetgeving. Want daar waar rechtsontwikkeling vaak een langzaam en omslachtig proces is, gaat de ontwikkeling van AI in een razendsnel tempo door. Als John de Koning – als AI-gegenereerde artiest – met dé Nederlandse zomerhit van 2024 ‘Zo Zomer’ in de Top 40 kan terechtkomen, wie weet wat ons de komende jaren te wachten staat.

Noten

1 ICT & Health, AI in ziekenhuizen: stand van zaken.

2 J.T. Hiemstra, De aansprakelijkheid voor ongeschikte hulpzaken, Deventer: Wolters Kluwer 2018, p. 95.

3 Graaf & Wuisman 2021, ‘Contractuele aansprakelijkheid voor het gebruik van AI-systemen in het licht van Europese voorstellen’, WPNR 2021, afl. 7348, p. 913 t/m 915.

4 MvA II, Parlementaire Geschiedenis Boek 6, p. 271-272.

5 H.B. Kolfschoten, ‘Eerste stappen in Europese regulering van artificiële intelligentie: algoritmes en patiëntenrechten’, Tijdschrift voor Gezondheidsrecht 2021, alf. 4, p.4.

6 G. 706/88, PbEG 1989, C 114/42.

7 L. Dommering-van Rongen, Productaansprakelijkheid, Deventer: Kluwer 2000.

8 Sapci A.H., Sapci, H.A. 2019, Innovative Assisted Living Tools, Remote Monitoring Technologies, Artificial Intelligence-Driven Solutions, and Robotic Systems for Aging Societies: Systematic Review.

9 Siemens Healtineers, Kunstmatige intelligentie maakt klinische besluitvorming beter, sneller en transparanter.

10 Nature Medicine 26, p. 1224-1228 (2020).

11 Pesapane, Eur Radiol Exp 2018.

12 Aboshiha, Gallagher & Gargan 2019.

13 LUMC, LUMC ontwikkelt AI voor robot-geassisteerde prostaatkankeroperaties.

Keywords

Vindplaatsen

Auteur(s)

Jurist algemeen verbintenissenrecht bij ARAG